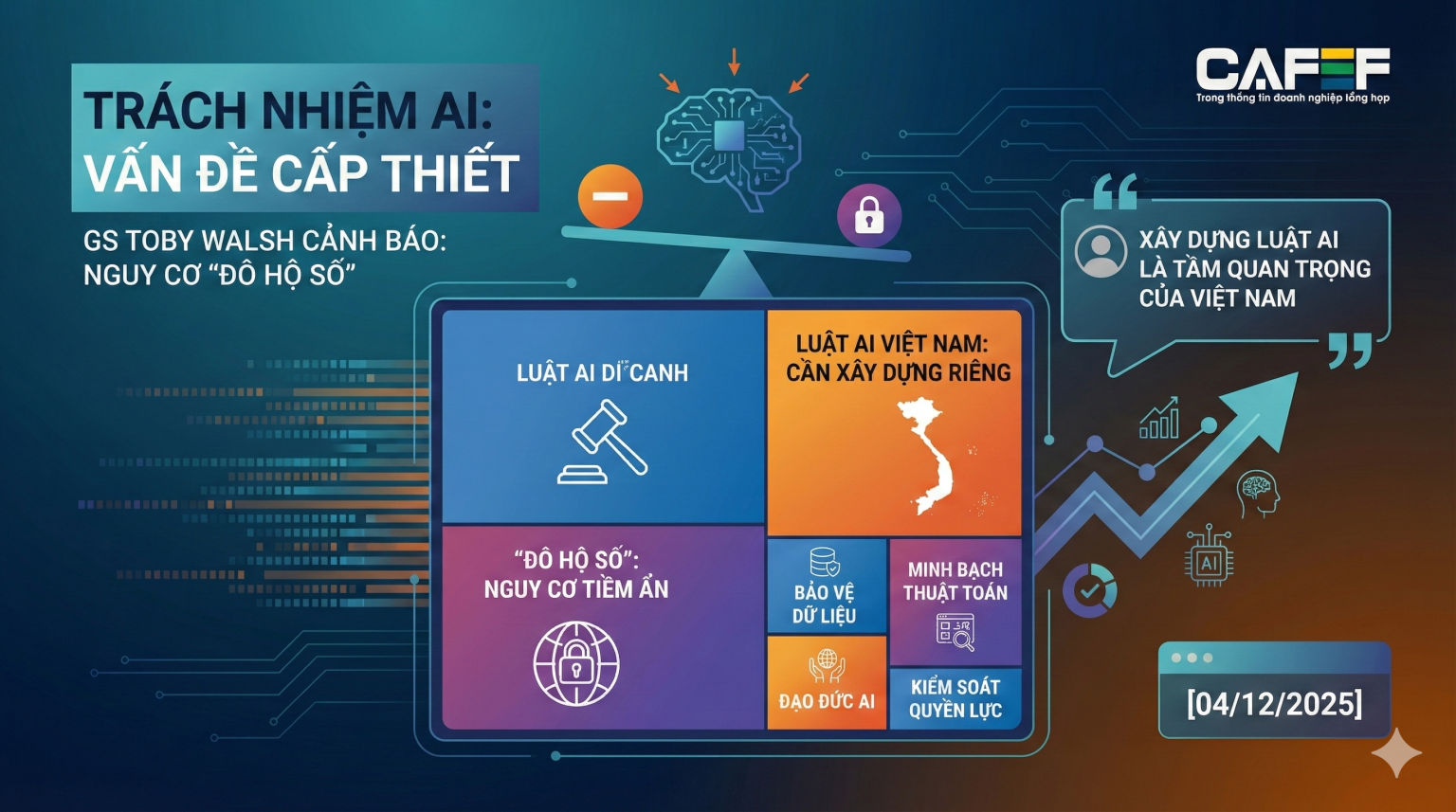

Trong bối cảnh trí tuệ nhân tạo (AI) phát triển mạnh mẽ, các quốc gia đang phát triển đối mặt với nguy cơ bị ‘đô hộ số’ nếu không chủ động kiểm soát nguồn tài nguyên dữ liệu. Đây là cảnh báo được Giáo sư Toby Walsh, một trong những chuyên gia hàng đầu thế giới về AI từ Đại học New South Wales (Australia), đưa ra bên lề Tuần lễ khoa học VinFuture 2025, nhấn mạnh tầm quan trọng của việc Việt Nam xây dựng một hành lang pháp lý riêng cho lĩnh vực này.

Nguy cơ ‘đô hộ số’ và sự cần thiết của luật pháp

Theo Giáo sư Toby Walsh, dữ liệu đã trở thành một loại tài nguyên mới. Nếu các quốc gia đang phát triển, vốn từng bị đô hộ về mặt vật lý, để dữ liệu bị khai thác tự do mà không có sự kiểm soát, họ có nguy cơ trở thành ‘nguồn lực giá rẻ’ trong hệ sinh thái AI toàn cầu, dẫn đến một hình thái ‘đô hộ số’. Ông nhấn mạnh rằng các giá trị và văn hóa của mỗi quốc gia là khác biệt, và không thể kỳ vọng các công ty công nghệ nước ngoài sẽ tự động bảo vệ những đặc trưng này.

Ông cho rằng việc chủ động bảo vệ văn hóa và ngôn ngữ là trách nhiệm của chính mỗi quốc gia. Do đó, việc xây dựng một bộ luật chuyên biệt về AI, như Việt Nam đang thực hiện, là một bước đi quan trọng để giữ vững quyền tự chủ. Giáo sư Walsh bày tỏ sự ủng hộ đối với việc Việt Nam là một trong những quốc gia tiên phong trong lĩnh vực này, coi đây là công cụ cần thiết để bảo vệ các giá trị riêng.

Trách nhiệm AI và các rủi ro tiềm ẩn

Giáo sư Walsh khẳng định không thể chỉ dựa vào thiện chí của thị trường, vì lợi nhuận khổng lồ từ AI có thể thúc đẩy doanh nghiệp vượt qua các giới hạn đạo đức. Ông cho rằng cách duy nhất để đảm bảo hành vi đúng đắn là áp dụng các quy định nghiêm ngặt, trong đó việc sử dụng AI có trách nhiệm phải là yêu cầu bắt buộc. Vấn đề **trách nhiệm AI** trở nên cấp thiết khi các hệ thống này ngày càng có khả năng ra quyết định và hành động độc lập.

Một ví dụ điển hình được đưa ra là hệ thống AI tại Mỹ dùng để đề xuất mức án tù. Do được huấn luyện trên dữ liệu lịch sử chứa đựng định kiến, mô hình này có xu hướng đề xuất mức án nặng hơn đối với người da đen. Khi AI gây ra sai lầm, câu hỏi về trách nhiệm được đặt ra. Theo ông Walsh, trách nhiệm này phải thuộc về các công ty triển khai và vận hành hệ thống AI, buộc họ phải chịu hậu quả cho những gì ‘cỗ máy’ của mình gây ra.

Ngoài ra, các rủi ro về sức khỏe tinh thần cũng được cảnh báo. Ông đề cập đến các vụ kiện ở Mỹ, nơi phụ huynh cáo buộc chatbot công nghệ là nguyên nhân dẫn đến việc con cái họ tự tử. Ngay cả khi tỷ lệ người dùng ChatGPT gặp vấn đề tâm lý chỉ chiếm vài phần trăm, con số tuyệt đối cũng có thể lên tới hàng trăm nghìn người. Ông cũng cho rằng các bài học từ mạng xã hội về bảo vệ trẻ em cần được cân nhắc áp dụng cho AI, ví dụ như quy định về giới hạn độ tuổi sử dụng.

Định hướng cho Việt Nam và nội dung dự thảo Luật AI

Giáo sư Walsh khuyến nghị Việt Nam nên chủ động, không chờ đợi chuyển giao công nghệ hay định hướng từ bên ngoài. Lời khuyên của ông là tập trung đầu tư vào con người, nâng cao kỹ năng và hiểu biết về AI cho người dân, đồng thời phát triển một hệ sinh thái AI trong nước. Các quy định pháp luật hiện hành như luật về quyền riêng tư hay luật cạnh tranh cũng có thể được áp dụng trong không gian số.

Về phía Việt Nam, dự thảo Luật AI đang được xây dựng dựa trên tám nguyên tắc cơ bản, với nguyên tắc quan trọng nhất là ‘lấy con người làm trung tâm’, đảm bảo AI tôn trọng nhân phẩm, quyền riêng tư và giá trị văn hóa. Dự thảo cũng phân loại công nghệ AI theo bốn mức độ rủi ro, trong đó các hệ thống thuộc nhóm rủi ro không chấp nhận được sẽ bị cấm. Nhóm này bao gồm các hệ thống có khả năng thao túng hành vi, tấn công nhóm yếu thế, hoặc tạo ra nội dung giả mạo gây nguy hại an ninh quốc gia. Theo Bộ Khoa học và Công nghệ, mục tiêu của luật là tạo ra một hành lang pháp lý ‘thông thoáng và an toàn’ để thúc đẩy phát triển, không phải để siết chặt quản lý.

Song song với việc hoàn thiện luật, Việt Nam cũng đang đẩy mạnh đầu tư vào hạ tầng tính toán, nguồn lực tài chính và đào tạo nhân lực chuyên sâu cho ngành AI, thể hiện sự tiếp cận toàn diện trong việc quản lý và phát triển công nghệ này.